¿El secreto para proteger los datos de la empresa utilizando IA generativa? Pregúntaselo a Guardian.

24 de enero de 2025

Aproveche el poder de la IA generativa para mejorar la eficacia y reducir los costes sin comprometer la seguridad de los datos.

La inteligencia artificial generativa se está generalizando, integrándose en los procesos de negocio de las empresas y prometiendo operaciones optimizadas y ahorro de costes. Sin embargo, la preocupación por la exposición de datos confidenciales a los modelos de lenguaje de gran tamaño (LLM) ha hecho que las organizaciones duden a la hora de adoptar la tecnología, especialmente cuando se trata de información crítica sobre sus procesos, tecnología y usuarios.

Una encuesta reciente de Cisco descubrió que más de 1 de cada 4 organizaciones ha prohibido la IA generativa debido a la preocupación por la privacidad y la seguridad de los datos. Esto pone de relieve la importante tensión existente entre el deseo de innovar con IA y la necesidad crítica de proteger los datos empresariales.

Explorar los riesgos de la exposición de datos

Las organizaciones se enfrentan a retos únicos a la hora de salvaguardar dos tipos de datos:

- Datos estructurados: Almacenados en bases de datos relacionales en forma de tablas y columnas

- Datos no estructurados: Se encuentra en documentos, políticas, procesos, imágenes y artículos de conocimiento.

Los LLM necesitan acceder a los datos para aprender y generar resultados contextualmente relevantes. Sin embargo, exponer los datos de la empresa a los LLM introduce riesgos adicionales, como se ilustra en estos escenarios:

Escenario 1: Exposición de datos empresariales sensibles

Imaginemos que un proveedor de ERP empresarial utiliza LLM para ayudar en la generación de facturas basadas en NLP. Al proporcionar datos confidenciales como números de pieza, precios unitarios y políticas de descuento, la organización se arriesga a una exposición indirecta. Si otro usuario pregunta: "¿Cuál es el descuento típico para organizaciones sin ánimo de lucro?", podría revelar inadvertidamente información sensible obtenida por el LLM.

Este problema de exposición de datos se produce cuando los LLM utilizan involuntariamente la información aprendida fuera de su contexto previsto, lo que conlleva riesgos empresariales potenciales.

Escenario 2: Infracciones de la normativa en todas las zonas geográficas

Las organizaciones que operan en varias regiones deben cumplir estrictas normativas de privacidad y localización de datos. Por ejemplo, la información personal de los empleados europeos no puede compartirse fuera de Europa. Exponer estos datos a los LLM podría violar acuerdos de tratamiento de datos y traspasar los límites reglamentarios y de cumplimiento.

Amenazas y vulnerabilidades emergentes

A medida que evoluciona la IA generativa, también lo hacen sus riesgos. Los primeros en adoptarla deben tener en cuenta las vulnerabilidades de la infraestructura, las redes y las aplicaciones. Algunos riesgos notables incluyen:

- Filtración de datos del LLM: Revelaciones involuntarias de información sensible de dominio privado

- Ataques de inyección puntual: Consultas manipulativas diseñadas para extraer datos confidenciales

- Modelo de robo: El acceso no autorizado o la manipulación de modelos LLM.

Herramientas actuales y sus limitaciones

Aunque los proveedores de LLM y terceras empresas ofrecen herramientas para la seguridad de los datos, estas soluciones se centran principalmente en los datos no estructurados (como los documentos). A menudo no abordan el problema de fondo de la exposición de datos estructurados.

Por ejemplo, las técnicas de enmascaramiento de datos pueden ocultar información sensible durante la formación de los LLM. Sin embargo, no evitan que los LLM aprendan inadvertidamente tendencias o promedios con potencial de uso indebido a través de los límites de la organización.

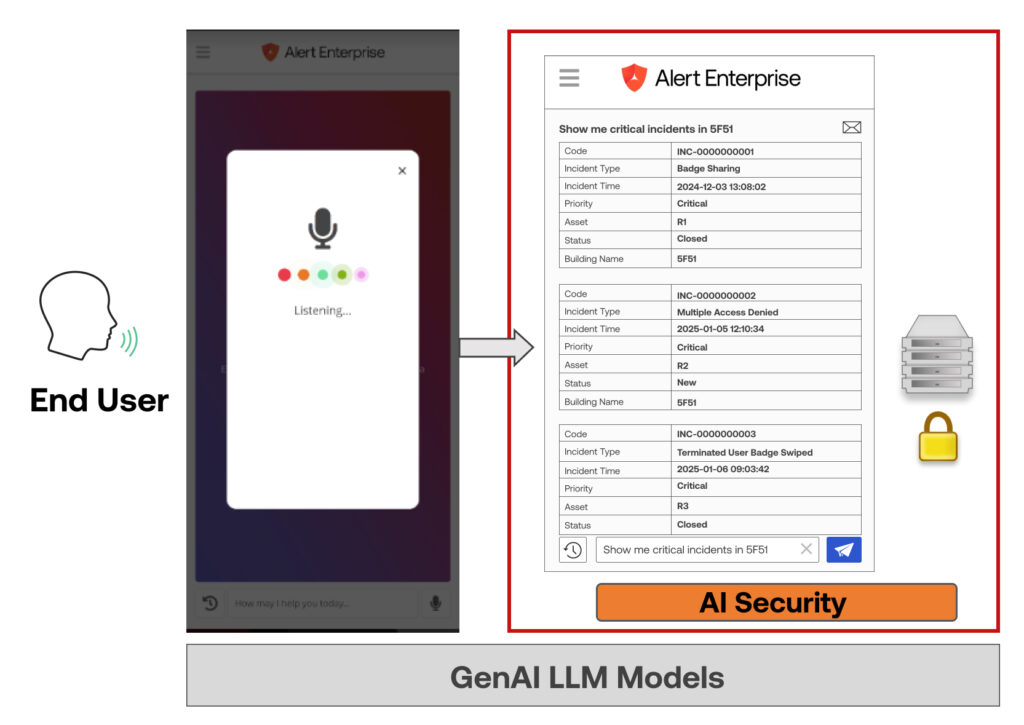

Una solución integral: El enfoque de Alert Enterprise

La forma más eficaz de proteger los datos empresariales es impedir por completo que los LLM accedan a los datos estructurados reales. Alert Enterprise ha desarrollado una tecnología patentada para conseguirlo exponiendo los LLM únicamente a metadatos, como estructuras de tablas y entidades. El LLM utiliza el Procesamiento del Lenguaje Natural (PLN) para convertir las consultas en metadatos, que luego la aplicación traduce a una sintaxis legible por máquina para obtener los datos de forma segura.

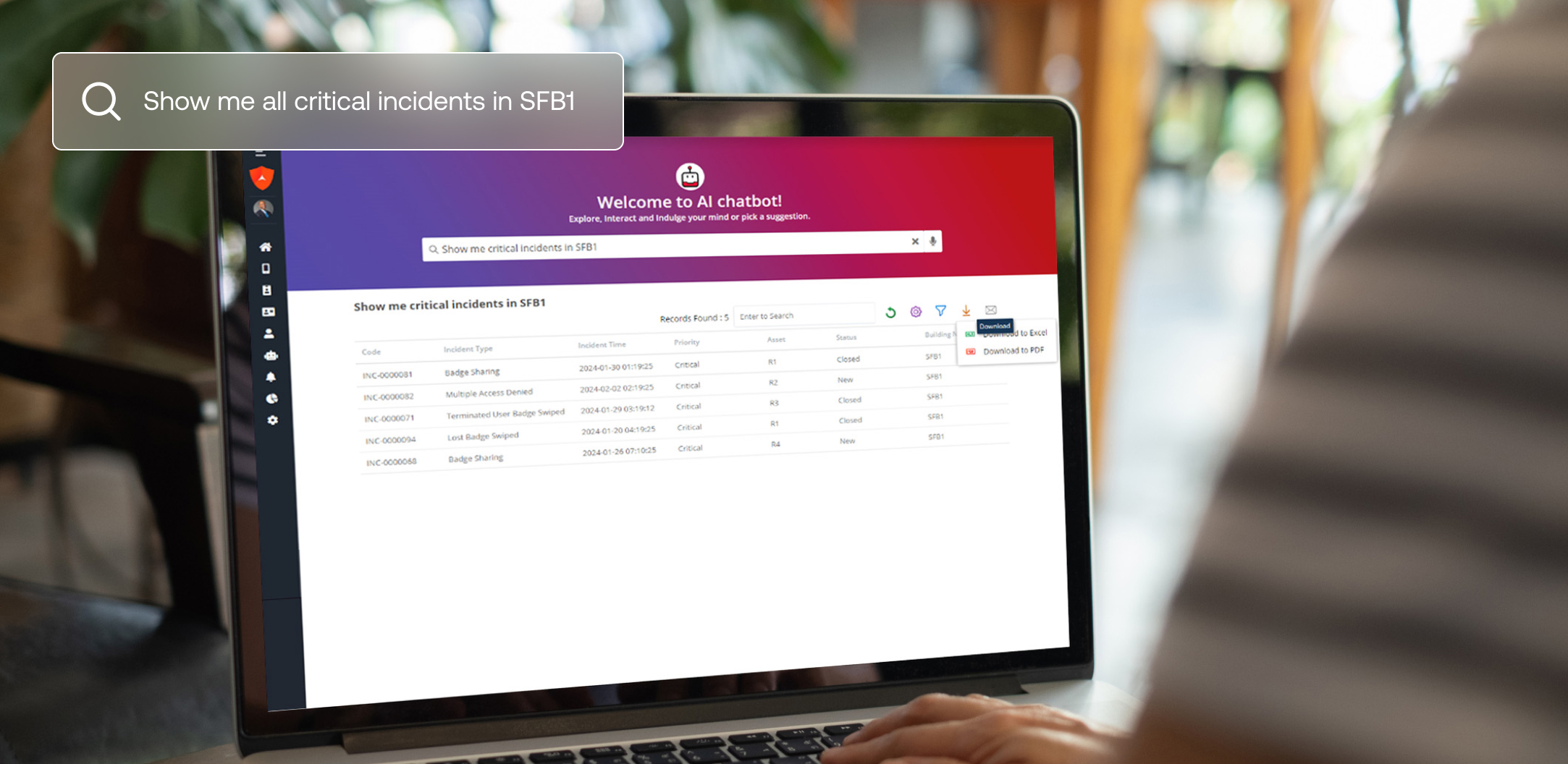

Nuestra Chatbot de inteligencia artificial de Guardian Security se basa en esta tecnología y permite a los usuarios formular preguntas de análisis de datos en lenguaje natural. El chatbot proporciona respuestas instantáneas y precisas sin comprometer datos sensibles.

Este enfoque innovador garantiza:

- Los LLM nunca acceden a los datos en bruto, lo que elimina los riesgos de exposición.

- Las empresas conservan el control total de sus datos estructurados, manteniendo la conformidad en todas las regiones y departamentos.

¿Quiere saber más?

Explore nuestra innovadora patente de privacidad de datos de IA generativa aquí.